Analyse de Sculpting the Air (2010-2015) de Jesper Nordin

Introduction : contexte, concept et méthode

Le compositeur et son projet

Jesper Nordin est une figure singulière dans le paysage de la musique contemporaine. Issu des musiques rock et électronique, il compose ses premiers morceaux à l’oreille en recourant à des séquenceurs, des boîtes à rythme et des claviers. Ce n’est qu’à vingt et un ans qu’il se forme à l’écriture de tradition “savante” mais il éprouve toujours le besoin d’être au contact de la matière sonore, c’est pourquoi il improvise régulièrement et de longue date avec des musiciens de différents horizons. Cette approche est une composante essentielle de son processus de création. Elle l’incite à développer à partir de 2007 ses propres outils compositionnels. Voici comment il relate cette trajectoire, entre écriture savante et interaction avec l’électronique en temps réel :

Même si j’ai l’habitude d’écrire de la musique pour orchestre ou pour ensemble, j’enregistre les musiciens pour construire avec l’ordinateur des maquettes et les transcrire. Progressivement, je mets de plus en plus d’énergie dans la maquette, et de moins en moins dans la partition [...] J’aime contrôler de façon intuitive et improvisée les ébauches de la partition, sans avoir besoin qu’elle soit entièrement écrite. J’ai observé de nombreuses personnes travailler avec des surfaces tactiles ou des tablettes pour jouer des sons de différente manière. Je me suis dit que je pourrais contrôler des messages MIDI et générer de la musique comme cela, et créer un genre d’instrument sur lequel j’aurais toujours un contrôle d’ordre compositionnel. J’ai donc créé ce patch Max en 2007. J’ai réparti les hauteurs et les durées sur un grille, mais je ne voulais pas contrôler un seul instrument : la pointe du stylet devait me permettre de contrôler un orchestre entier. [Jesper Nordin, 10 novembre 2014, Arch. Ircam – Bacot-Féron, notre traduction]

Co-commandée par l’Ircam-Centre Pompidou et le Grame dans le cadre du projet INEDIT financé par l’Agence Nationale de la Recherche, avec la participation du Statens musikverk – Music development and heritage Sweden, Sculpting the Air relève autant d’un projet artistique que d’un programme de recherche scientifique. L’originalité de cette œuvre créée par l’ensemble TM+ sous la direction de Marc Desmons, le 13 juin 2015 à la Maison de la musique de Nanterre, tient au fait que les gestes du chef d’orchestre servent aussi à contrôler la partie électronique grâce à un dispositif technologique complexe imaginé par le compositeur avec le concours du Réalisateur en Informatique Musicale (désormais RIM) Manuel Poletti. Pensée à la manière d’un concerto pour chef d’orchestre, Sculpting the Air est le premier volet d’une trilogie dans laquelle des outils interactifs sont développés pour explorer musicalement et visuellement le concept d’exformation.

L’exformation

L’exformation est un concept introduit par l’auteur Danois de science-fiction et de vulgarisation Tor Nørretranders dans l’un de ses livres publiés en 1992 et traduit ultérieurement en anglais sous le titre The User illusion [Nørretranders, 1992/1998]. Dans ce livre, l’auteur explique que tout message ne transmet pas uniquement de l’information, il contient aussi une part (souvent majoritaire) d’exformation, c’est-à-dire de l’information qui n'est volontairement pas transmise de façon explicite. L’exformation réside dans le contexte dans lequel l’information est émise. Si elle n’est pas consciente, elle est omniprésente et porteuse de sens. Nørretranders, pour illustrer cette idée, cite l’exemple de Hugo, parti en vacances après la publication des Misérables, et envoyant une lettre à son éditeur pour s’enquérir de l’accueil du public. Le texte intégral de la missive de Hugo est le suivant : ‘?’. La réponse de son éditeur, en retour, est : ‘!’.

Le point d’interrogation de Hugo résulte d’un rejet volontaire de l’information. Il ne s’agit pas pour autant d’une omission pure et simple, comme s’il avait oublié cette information. Il fait délibérément référence à l’information non incluse, même si du point de vue épistolaire, elle est omise. Dans ce livre, nous appellerons exformation une information qui est explicitement exclue.

Un message a une profondeur s’il contient beaucoup d’exformation. Si une personne donnée, pendant le processus de formulation finale d’un message, en exclut délibérément des informations de telle sorte qu’elles n’y sont pas explicitement transmises, il y a de l’exformation.

Il n’est pas possible de mesurer la quantité d’exformation d’un message à partir de son seul contenu : le contexte seul peut nous le dire. L’expéditeur met en forme le message pour qu’il reflète l’information qu’il a en tête. [Nørretranders, 1998, p. 92, notre traduction]

Nordin citera l’exemple de la correspondance de Hugo avec son éditeur à de nombreuses reprises pour expliquer d’où vient le concept qui inspire son projet. Dans Sculpting the Air – sous-titrée Gestural exformation –, le compositeur souhaite mettre en exergue à la fois l’information et l’exformation contenues dans la gestique du chef :

L’exformation […] désigne tout ce qui n’est pas dit effectivement, mais qui est présent dans nos pensées au moment de parler, ou avant de formuler les choses – là où l’information est le discours mesurable et démontrable que nous prononçons réellement.

Les gestes du chef comprennent donc de nombreuses exformations qui, bien sûr, diffèrent grandement selon la personne qui les regarde (musicien, auditeur...). Mais la quantité relativement restreinte d’informations mesurables dans ses mouvements se prête parfaitement à une première expérience fouillée des exformations du point de vue musical. On prendra par exemple les gestes ordinaires du chef pour les placer dans un contexte nouveau et étendu, dans lequel leurs effets seront différents. [Nordin, 2015]

L’idée première que Nordin souhaite mettre en œuvre dans cette trilogie fondée sur le concept d’exformation consiste à “décentraliser l’électronique en jouant sur la répartition de plusieurs petits modules au lieu de n’en avoir qu’un” [Arch. Ircam – Note d’intention, 2014, « Projet Nordin STA TM + presentation », transmis par C. Béros]. Ainsi les musiciens auraient à ses yeux un meilleur contrôle sur la partie électronique, en particulier en ce qui concerne les traitements en temps réel. Dans Sculpting the Air, le premier volet de la trilogie, les gestes du chef d’orchestre délivrent l’information de direction habituelle aux musiciens, mais ils servent aussi à contrôler l’électronique et à activer des clochettes, rendant ainsi visible leur dimension « exformationnelle ». Tout en gardant la forme des gestes de direction, Nordin les fait littéralement sortir du cadre en les dotant d’un sens nouveau qui n’a plus pour but d’interagir avec les musiciens. Dans Visual Exformation, le deuxième volet de la trilogie, qui a été créé le 4 octobre 2016 par le Quatuor Diotima (son dédicataire), les quatre musiciens contrôlent à travers leurs gestes la partie électronique et la structure de diodes électroluminescentes qui les entourent. Le troisième volet n’a pas été encore composé mais devrait s’appeler Interactive Exformation et être créé par l’Ensemble Recherche.

Une analyse située du processus de création

La méthodologie visant à rendre compte de la démarche de création de Sculpting the Air s’appuie sur un corpus de données recueillies au cours de l’observation des séances de travail qui se sont déroulées par blocs entre août 2014 et juin 2015 [Bacot et Féron, 2016]. L'analyse de ce corpus, formé in situ, éclaire ainsi des pans de la créativité musicale dans un contexte technologique, au plus près des décisions qui motivent la conception des interfaces de captation du geste : il permet de retracer les étapes qui rendent la performance possible, depuis la proposition écrite du projet jusqu’à la création publique. Hormis la première séance avec le chef d’orchestre Nicolas Agullo – qui ne poursuivra pas ce projet en raison d’incompatibilités de calendrier –, les autres séances ont pu être observées et captées en vidéo, ce qui a permis de constituer un ensemble de données conséquent. Des entretiens de remise en situation ont par ailleurs été menés avec le compositeur et le chef d’orchestre afin de revenir avec eux sur les étapes du processus de création.

Au-delà de l'analyse de l’œuvre elle-même (au sens classique), ce texte met l’accent sur la démarche de création collective, dans laquelle les paramètres d'exécution de la pièce sont progressivement ajustés suite aux essais et aux discussions menés au cours de la résidence. Autrement dit, cette analyse révèle comment Nordin élabore le dispositif technologique et le matériau musical en collaborant étroitement avec Poletti, Desmons et les musiciens de TM+. Le RIM a pour mission d’assurer la réalisation technique de l’œuvre et sa pérennité, de la création des programmes informatiques pour l'analyse et le traitement du son en temps réel à leur adaptation pour d’éventuelles représentations ultérieures [Zattra et Donin, 2016]. Le chef d'orchestre, du fait de son rôle central dans l’utilisation du dispositif technologique, est naturellement amené à dialoguer avec le compositeur et le RIM, à faire des propositions et à négocier les conditions dans lesquelles il appréhende et incarne la pièce. Cela est valable également, quoique dans une moindre mesure, pour les musiciens de l’ensemble. En se penchant sur la genèse et la réalisation de Sculpting the Air et en passant en revue les différents aspects technologiques, gestuels et notationnels, cette analyse souhaite révéler les aspects dynamique et collaboratif du processus de création.

Les applications Gestrument et ScaleGen

Origines des outils

L’une des singularités techniques de l'œuvre tient au fait qu’elle repose sur des applications mises au point par Jesper Nordin lui-même : Gestrument et ScaleGen. Elles résultent d’un processus d’adaptation matériel, logiciel et créatif s’étalant sur plusieurs années et constituent le cœur technologique de l’Exformation trilogy. Avant d’en détailler les fonctionnalités, il est important d’en retracer brièvement la genèse pour comprendre leurs rôles tant dans le processus compositionnel des œuvres que dans la conception des dispositifs interactifs.

L’application Gestrument a initialement été conçue par Nordin comme un outil d’aide à la composition servant à générer un réservoir de matériaux, et non comme un programme prenant en charge la gestion des parties électroniques des œuvres. En 2007, il compose Undercurrents – une commande du Grame – et utilise alors une tablette graphique et son stylet pour contrôler un patch Max lui permettant d’improviser sur différentes échelles musicales. On peut en voir une démonstration ci-dessous, enregistrée au cours de la résidence de Nordin au Grame en 2011, alors qu’il travaillait sur Frames in Transit [Média 1]. L’interface choisie ici pose les bases du mode d’interaction gestuelle proposée par la suite dans l’application Gestrument qui sera commercialisée à partir de 2012.

Média 1. Improvisation avec une tablette Wacom sur une échelle musicale microtonale. Ce dispositif a initialement été développé par Nordin en 2007 au sein du Grame (Lyon) avec le concours de Christophe Lebreton [© EV Grame, 2011].

Gestrument

C’est donc en 2012, sur la base du code Max de son programme d’aide à la composition, que le compositeur met au point, avec le concours du développeur Jonathan Liljedahl, l’application Gestrument destinée à des appareils mobiles à interface tactile fonctionnant sous iOS. L’idée de cette application est de plonger dans l’“ADN musical” d’une chanson, d’un artiste ou d’un genre tel que le métal, la techno, la musique classique indienne, le jazz ou la trance. Il est également possible de connecter des appareils prenant en charge le protocole MIDI, par exemple pour associer d’autres timbres aux contenus informationnels générés par l’application. Il faut noter qu’en 2018, Gestrument devient un système hérité (dit aussi version “legacy” : l’application n’est plus disponible au téléchargement ni supportée) au profit de Gestrument Pro. La création de Sculpting the Air ayant eu lieu en juin 2015, il n’est question dans ce texte que de la première version de Gestrument, et non de Gestrument Pro.

L’application présente une surface de jeu, sur laquelle un ensemble de durées est assigné en abscisse et une série de hauteurs en ordonnée. L’utilisateur génère ainsi du matériau musical en balayant l’écran du doigt; les hauteurs et les durées produites correspondent alors aux coordonnées de la trajectoire dessinée sur l’écran. La position du doigt sur l’écran déclenche la lecture de sons acoustiques ou électroniques et il est possible d'ajuster le nombre de voix jouées par l’application (de une à huit simultanément). Les instruments ont différentes plages de hauteurs, de durées et de dynamiques, qui varient en fonction de la position du doigt sur l’écran (le “multitouch” n'est pas pris en charge dans cette version de l’application). Si le doigt reste immobile sur un point de la tablette, la note ou l’accord est joué en boucle selon la durée sélectionnée et le tempo choisi. Les durées ne sont pas déclenchées si le mode “densité de pulsation” n’est pas activé, ce qui permet alors de jouer legato. Par ces moyens, l’utilisateur est en mesure d’improviser selon des combinaisons d’échelles de hauteurs, de timbres, de durées et de dynamiques définies, de conserver le résultat dans la mémoire du programme et de rappeler ces paramètres en un clic. Le matériau musical est ainsi généré en fonction du point de contact du doigt sur l’écran [Média 2].

**Média 2. Trailer officiel de Gestrument montrant les grands principes de fonctionnement cette application [© EV Gestrument, 2014]. **

Dans Frames in Transit, pièce écrite en 2012 pour orchestre et le Trio Trespassing, composé de Daniel Frankel au violon, Niklas Brommare aux percussions et Nordin lui-même à l’électronique, le compositeur contrôle pour la première fois Gestrument depuis la scène non plus à partir d’une surface tactile mais par le biais d’une caméra Kinect qui permet de capter ses gestes. Le compositeur recourt à nouveau à ce type de dispositif dans Sculpting the Air. Deux Kinects formeront des espaces de captation dans lesquels vont se déployer, sous forme gestuelle, les exformations de la direction d’orchestre. Cette idée maîtresse est donc le fruit d’un long processus de réflexion portant à la fois sur le travail de composition et sur la manière d’optimiser l’interaction avec l’électronique. Dès lors que Nordin s’est engagé dans la conception de son Exformation Trilogy, Gestrument est devenu l’un des points d’ancrage de sa démarche artistique.

ScaleGen

Une autre partie du code du programme Max conçu par Nordin a donné lieu à la création de ScaleGen, une application distincte de Gestrument dédiée spécifiquement à la création et l’édition d’échelles musicales. Elle permet de définir avec précision chaque hauteur (au centième de ton, ou en entrant manuellement une fréquence) et de construire des échelles non octaviantes [Média 3]. Les échelles ainsi générées peuvent être écoutées directement dans l’application, être exportées dans différents formats, ou bien être jouées par des instruments virtuels, eux-mêmes éventuellement contrôlés par un appareil externe via les protocoles MIDI ou OSC. De ce fait, il est aussi très simple d’importer une échelle dans Gestrument et d’improviser avec elle.

Média 3. Vidéo de démonstration de ScaleGen montrant à la fois sa simplicité d’utilisation mais aussi sa grande complémentarité avec Gestrument [© EV ScaleGen, 2014].

Processus de création collaboratif

Calendrier de production

La réalisation de Sculpting the Air s’est étalée sur presque une année entière, entre août 2014 et juin 2015. Au cours de cette longue période, Nordin a effectué quatre séjours de recherche (d’une à deux semaines) au sein de l’Ircam où il a collaboré étroitement avec le RIM et le chef d’orchestre, de manière à concevoir un dispositif technologique unique qui repose sur la dimension aérienne sans contact du geste musical, et qui se doit d’être le plus stable et ergonomique possible [Bacot et Féron, 2016].

Première séance (août 2014) – Improviser pour générer du matériau et définir le dispositif.

Nordin se rend à l’Ircam en août 2014 avec le matériel utilisé dans Frames in Transit deux ans auparavant, à savoir une tablette iPad et une caméra Kinect. Il apporte aussi quelques clochettes chinoises en porcelaine. Les discussions avec le RIM se concentrent essentiellement sur les possibilités offertes par les différentes technologies de capture de mouvement et sur l’éventuelle conception d’un système “fait maison”. Mais la configuration techno-instrumentale utilisée dans Frames in Transit fonctionnant correctement, il est décidé de l’adapter dans Sculpting the Air. Afin de concrétiser au mieux l’idée d’un concerto pour chef d’orchestre et d’identifier les possibilités et impossibilités offertes par le dispositif, des essais sont réalisés avec le chef d’orchestre Nicolas Agullo : déclenchement de sons par le biais de clochettes qui entrent dans le champ de captation de la Kinect, mise en boucle et gel de motifs instrumentaux (sous forme de fichier MIDI), improvisation sur une gamme microtonale d’inspiration suédoise à partir de Gestrument.

C’est également durant cette période que Nordin génère du matériau sous forme de fichiers MIDI en improvisant différents gestes dans le champ de la Kinect ou en utilisant les clochettes comme des pendules qui entrent périodiquement dans ce même champ. Les applications Gestrument et ScaleGen ne sont pas que des outils de performances mais servent également à générer de la matière sonore. L’improvisation fait bien partie intégrante du processus créateur car elle permet d’explorer de nouvelles voies à travers la manipulation d’une interface gestuelle intuitive, mais aussi de s’éloigner de la tentation d’imiter d’autres compositeurs ou de se répéter [Arch. Ircam – Bacot-Féron, 13/11/2014]. Avec ScaleGen, le compositeur crée d’abord des échelles microtonales uniques, dont certaines sont, d’après Nordin, issues de la musique folklorique suédoise. Il les importe ensuite dans Gestrument et improvise avec cette application pour produire un réservoir de phrases et d’harmonies. Les flux audio et MIDI résultant de ces moments d’expérimentation sont conservés afin de faciliter l’extraction et l’édition a posteriori de la matière musicale ainsi produite.

C’est à la suite de cette séance préparatoire que le compositeur rédige un court texte dans lequel il pose les bases de sa trilogie et indique les actions fondamentales que le chef devra effectuer dans Sculpting the Air : “1) Diriger l’ensemble comme à l’accoutumée; 2) Contrôler l’électronique (par le biais d’une caméra Kinect ou Leap Motion et/ou directement sur un iPad); 3) Jouer avec des objets physiques (arbre à clochettes fait sur mesure) par le mouvement des mains. ” [Arch. Ircam – Production, 2014]. Le cadre technologique des traitements électroniques en temps réel étant maintenant entériné, Nordin peut désormais se consacrer pleinement à l’écriture de la pièce.

Deuxième séance (novembre 2014) – Tester les effets temps réel en simulant la direction d’orchestre.

C’est au cours de cette séance que le chef d’orchestre Marc Desmons rencontre pour la première fois Nordin et Poletti qui lui expliquent les enjeux du dispositif technologique et l’utilisation des clochettes qui seront tantôt orientées vers les Kinects pour être utilisées comme des pendules [Figure 1a], tantôt face à lui pour être jouées tout en assurant la battue [Figure 1b]. À cette époque, le dispositif est encore assez rudimentaire : un des arbres à clochettes est incomplet et le chef fait remarquer qu’il lui faudrait un retour visuel pour se repérer dans le champ de captation des Kinects. Si l’instrumentation, la structure formelle et temporelle de l’œuvre et les matériaux sonores sont déjà clairement définis par le compositeur, la première ébauche de la partition rend uniquement compte de la carrure temporelle (mesures, métriques et tempo) dans sa totalité avec ici et là quelques fragments musicaux partiellement composés. Plusieurs extraits MIDI de ce que joueront les musiciens ont en revanche été exportés, ce qui permet ainsi au chef d’expérimenter, en mimant la battue, les traitements électroniques qui leur seront associés. Cette pratique que l’on pourrait qualifier de “karaoké pour chef d’orchestre” a permis :

- d’ajuster le positionnement des différents éléments du dispositif (pupitre, deux arbres à clochettes mobiles, deux Kinects).

- d’évaluer les gestes que le chef pouvait ou ne pouvait pas accomplir pour contrôler correctement les effets électroniques tout en continuant à diriger les musiciens, et leur degré de précision.

- d’aborder la question de la notation des gestes sur la partition.

Figure 1. Marc Desmons (à gauche), Jesper Nordin (au milieu de dos) et Manuel Poletti (à droite) le 12 novembre 2014 dans le studio 5 de l’Ircam [© Arch. Ircam – Bacot-Féron].

Troisième séance (février-mars 2015) – Premiers essais avec des musiciens de l’ensemble TM+.

Durant la séance précédente, le chef ne pouvait se fier qu’à l’oreille pour deviner s’il interagissait bien avec l’électronique en entrant suffisamment dans le champ des deux Kinects. Un ordinateur portable à écran partagé a donc été installé pour lui permettre de voir si ses mains ou les clochettes entraient ou non dans les zones de capture de mouvement [Figures 2a et 2b]. Au lieu de développer un patch Max conséquent qui engloberait l’ensemble des traitements électroniques, il est décidé de recourir au logiciel Ableton Live pour plus de souplesse. Bien qu’incomplète, la partition est à ce moment suffisamment avancée pour que le chef puisse travailler son jeu avec l’électronique en mimant la battue sur les extraits de la partition lue au format MIDI. Des répétitions partielles sont par ailleurs organisées pour la première fois avec quelques musiciens de l’ensemble TM+, ce qui permet ainsi de faire un pas vers les conditions réelles d’exécution [Figure 2c]. Nordin a aussi travaillé en studio avec Florent Jodelet, le percussionniste de l’ensemble TM+, afin de collecter pour la partie électronique des matériaux sonores produits sur un piano à queue, un tam-tam, une grosse caisse, et divers objets tels que des ressorts, des chaînes et une poutre métallique [Figure 2d].

Figure 2. a) et b) Marc Desmons mimant la battue tout en actionnant des effets électroniques en entrant dans les champs de captation des Kinects (Ircam – studio 5, 24 février 2015). c) Expérimentation du dispositif avec quelques musiciens de l’ensemble TM+ (Ircam – studio 5, 26 février 2015). d) Séance d’enregistrement avec le percussionniste Florent Jodelet (à gauche), Jesper Nordin et l’ingénieur du son Martin Antiphon (de dos), le 5 mars 2015 dans le studio 2 de l’Ircam [© Arch. Ircam – Bacot-Féron].

Quatrième séance (juin 2015) – Répétitions avec l’ensemble et création.

Nordin finalise sa partition durant le mois d’avril et l’envoie au chef. Au cours de la dernière séance de travail, la pièce est d’abord intégralement répétée à l’Ircam par Desmons à partir de la lecture de la partition MIDI. Les premières répétitions en conditions réelles avec l’ensemble TM+ se déroulent alors au sein de la Maison de la Musique à Nanterre où sera créée la pièce le 13 juin 2015 [Figure 3]. À ce moment les discussions ne portent plus les aspects techniques et technologiques, qui sont désormais stabilisés, mais plutôt sur la manière d’aborder musicalement l’œuvre et d’assimiler au mieux les traitements électroniques.

Figure 3. a) Répétition avec l’ensemble TM+ le 10 juin 2015 à la Maison de la Musique de Nanterre. b) Régie située en fond de salle [© Arch. Ircam – Bacot-Féron].

Recherches gestuelles

Le SDK (kit de développement logiciel) du premier modèle de caméra Kinect (1414) permet aux développeurs de traiter les données transmises par le capteur de mouvement de la caméra. Dans Sculpting the Air, les gestes effectués par le chef dans les espaces de captation sont détectés par les Kinects, et les données numériques résultant de ces gestes (les pixels et leurs coordonnées) sont envoyées à Gestrument. Grâce au programme GestrumentKinectConverter, développé ad hoc pour la pièce, les données des Kinects sont transformées en notes MIDI qui peuvent dès lors activer l’application. Couplée à ce programme, l’application ne permet plus seulement de contrôler les instruments virtuels qui en reçoivent les données, mais aussi d’activer et de moduler des traitements électroniques en temps réel.

Au lieu de manipuler deux écrans tactiles, le dispositif met en scène deux espaces rectangulaires immatériels qui forment un espace d’interaction gestuelle avec l’électronique. Les Kinects servent ainsi de relais entre les gestes du chef d’orchestre et la position du point de jeu sur l’écran de l’application. Le chef peut donc à la fois diriger l’ensemble et entrer dans le champ des capteurs avec une similarité d’intention gestuelle, donnant au public l’impression d’une réciprocité entre l’activité de direction d’une part et le déclenchement des sons ou la modulation des effets électroniques d’autre part. La direction de l’œuvre est en quelque sorte contaminée par l’interaction avec l’électronique, et vice versa. Les deux tablettes prenant en charge les deux occurrences de Gestrument sont situées au centre de la régie. L’écran d’ordinateur placé devant le chef lui sert à visualiser son activité à l’intérieur des champs de captation des deux Kinects [Figure 2a et 2b].

Deux raisons principales ont motivé les répétitions sans musicien durant la deuxième séance de travail. D’une part, cela a permis à Desmons de mieux se familiariser avec les différentes actions gestuelles qu’il devait assurer parfois simultanément car aux changements de signatures rythmiques fréquents se superposent les gestes à réaliser directement dans le champ des Kinects [Média 4] ou pour mettre en mouvement les clochettes [Média 5]. D’autre part, l’interaction avec l’électronique étant une donnée nouvelle pour le chef, ces moments de répétition lui ont permis de tester la réponse du dispositif, et au RIM, de l’adapter sur mesure pour lui assurer le meilleur confort possible. Pour que les répétitions puissent se dérouler dans un contexte musical mais en l’absence des instrumentistes, la partition numérique était donc lue par des instruments virtuels. Une piste métronomique pouvait être ajoutée de manière à clarifier les changements de mesure et de tempo.

Média 4. Marc Desmons s’entraînant à battre la mesure tout en déclenchant les effets (Ircam – studio 5, 12 novembre 2014). Le fichier MIDI de la pièce est lu en playback avec un métronome. À la fin de ce passage, le compositeur et le chef discutent d’un aspect concret de la performance : la gestion de la tourne des pages et le contrôle gestuel des effets [© Arch. Ircam – Bacot-Féron].

Média 5. En entrant dans les espaces de captation, les clochettes déclenchent des échantillons de résonances d’un piano préparé (Ircam – studio 5, 12 novembre 2014) [© Arch. Ircam – Bacot-Féron].

Configuration finale

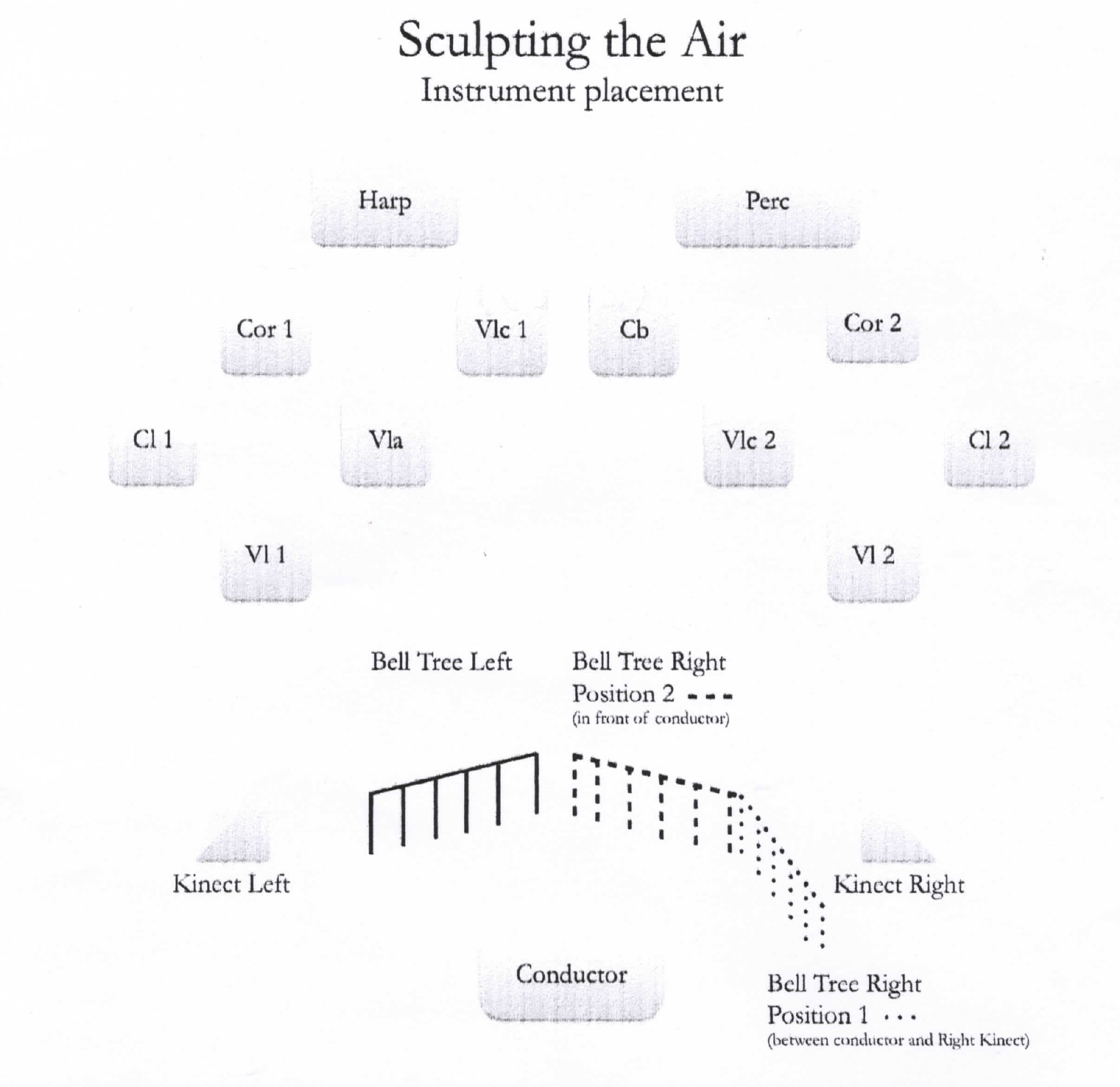

Les musiciens forment deux groupes positionnés devant le chef à gauche et à droite de la scène. L’ensemble de gauche est composé des instruments suivants : une clarinette en si b, un cor en fa, une harpe, un violon, un alto et un violoncelle. L’ensemble de droite est composé d’une clarinette en si b (à laquelle il faut parfois substituer une clarinette basse), d’un cor en fa, d’un violon, d’un violoncelle, d’une contrebasse et de percussions : vibraphone, caisse claire et grosse caisse préparée à l’aide de trois baguettes qui pendent à des cordes accrochées à son cercle pour ajouter un effet de vibration et de résonance lors de la frappe. La nature symétrique de cette disposition instrumentale est renforcée par le dispositif technologique, le chef ayant devant lui, à gauche comme à droite, une caméra Kinect et un “arbre à clochettes” [Figure 4].

Figure 4. Dispositif scénique [© Part. Peters, 2015].

Sur chaque arbre sont suspendues six clochettes en porcelaine ou en métal. L’arbre de gauche ne bouge jamais durant la pièce. Les clochettes sont toutes alignées à la même hauteur parallèlement à l’axe des épaules du chef qui, dans la seconde partie de l’œuvre uniquement, les met en mouvement de manière à ce qu’elles s’entrechoquent et résonnent. L’arbre à clochettes de droite doit en revanche pouvoir être manipulé durant la pièce. Dans la première partie de l’œuvre, les clochettes de cet arbre ne sont pas suspendues à la même hauteur et sont orientées de trois-quarts, dans l’alignement de la Kinect de droite et du chef [Figure 5a]. Ce dernier doit leur imprimer un mouvement pendulaire et le stopper sans qu’elles s’entrechoquent afin de pénétrer, à l’extrémité de leur trajectoire parabolique, dans le champ de captation de la Kinect pour déclencher alors un échantillon sonore. Durant l’intermède électroacoustique qui sépare les deux sections de l’œuvre, le chef réaligne verticalement les clochettes de cet arbre et les positionne face à lui afin de former, avec l’arbre de gauche, un rideau de clochettes [Figure 5b]. Le chef est alors invité de temps à autre à battre la mesure dans ce rideau afin qu’elles s’entrechoquent, ajoutant ainsi à la partie orchestrale des sons aigus à résonance prolongée.

Figure 5. Positionnement des arbres à clochettes durant la première section (a) et la deuxième section (b) de l’œuvre [© Arch. TM+].

Le dispositif technologique sur scène comprend les microphones qui servent à capter individuellement chaque instrumentiste, les deux Kinects, un écran d’ordinateur pour avoir un retour visuel des zones de captation des Kinects et un système de retour audio, ceux-ci ayant pour but d’optimiser l’équilibre entre parties électronique et instrumentale. Le reste du matériel est déporté en régie [Figure 3b] sous la surveillance attentive du compositeur et du RIM. Il se compose d’un contrôleur MIDI qui permet d’ajuster les volumes de l’électronique et de déclencher la lecture de la partie électroacoustique centrale séparant les deux sections de l’œuvre. En plus du contrôleur, la régie accueille les deux tablettes avec l’application Gestrument, et un ordinateur équipé de Live et Max, qui traite les données MIDI envoyées par GestrumentKinectConverter et renvoie le signal dans le système de diffusion de la salle. Les instruments virtuels issus de la banque Ircam Solo instruments sont mobilisés grâce la workstation UVI, un outil de lecture dédié. Il faut enfin ajouter que si les effets et les instruments virtuels sont diffusés sur les haut-parleurs de façade en stéréo, ils sont aussi projetés dans un système de diffusion spatialisé composé de huit haut-parleurs répartis sur scène et dans la salle, ce qui crée un espace sonore plus dynamique. Il est également possible d’ajouter quatre haut-parleurs supplémentaires pour accentuer le caractère immersif de la diffusion de la partie électronique.

La notation au prisme de l’organologie

La notation instrumentale est tout à fait classique, si on fait exception des “boîtes” (parties encadrées) au cours du premier mouvement dans lesquelles sont indiqués des motifs qui doivent être répétés par les musiciens suivant un tempo fixe ou des accelerendo (“repeat box faster and faster”). Dans de tels moments, le chef se focalise moins sur la direction des musiciens et peut alors être plus attentif à ses interactions avec l’électronique. La conduite des événements électroniques depuis la régie (lancement de la lecture de fichiers audio, activation ou désactivation des effets, par exemple) est indiquée sur une ligne en bas de la partition alors que les deux lignes sur la partie supérieure indiquent les actions que doit accomplir le chef avec sa main droite (portée supérieure) et sa main gauche (portée inférieure) [Figure 6].

Figure 6. Sculpting the Air, m.106-110 [© Part. Peters, 2015].

La singularité du projet compositionnel a conduit le compositeur à interroger le chef d’orchestre sur le type de notation à adopter. Finalement, la notation gestuelle n’est pas aussi détaillée que dans d’autres œuvres du répertoire contemporain. Le compositeur s’est plutôt concentré sur des gestes simples et a encouragé le chef à se fier à ses propres sensations pour contrôler au mieux l’électronique, quitte à moins tenir compte parfois de ce qui était noté sur la partition.

Concernant la mise en mouvement des clochettes, deux formes de notation sont explorées. Lorsqu’elles sont utilisées comme pendules pour déclencher des échantillons sonores, Nordin recourt en quelque sorte à ce que l’on pourrait appeler une portée hypertrophiée comprenant six lignes, chacune représentant une clochette [Figure 7]. Les notes reliées entre elles signalent le déclenchement périodique des échantillons sonores. Lorsqu’une seule note est indiquée, cela signifie que le chef doit stopper le pendule après seulement une oscillation.

Figure 7. Sculpting the Air, m.1 [© Part. Peters, 2015]. “Portée hypertrophiée” à 6 lignes où les notes représentent les échantillons sonores déclenchés par le mouvement pendulaire des clochettes.

Lorsque les clochettes sont utilisées de manière “classique”, Nordin recourt à une convention graphique simple. Cinq petits traits verticaux parallèles, enfermés dans une boîte, font référence aux fils auxquels sont suspendues les clochettes (qui sont en réalité six par arbre). Ces boîtes sont surmontés d’un acronyme infléchissant l’amplitude des gestes que doit opérer le chef : “NSA” pour “not so active”, “A” pour “active” ou “VA” pour “very active” [Figure 8].

Figure 8. Sculpting the Air, m.128 [© Part. Peters, 2015]. Boîtes spécifiant l’activité gestuelle du chef lorsqu’il doit faire s’entrechoquer les clochettes.

Les différents traitements électroniques que nous détaillons dans la section suivante sont indiqués sur la partition par leur nom. Les gestes que doit réaliser le chef pour contrôler ces traitements sont représentés dans de petites boîtes symbolisant le champ de captation des Kinects [Figure 9].**

Figure 9. Exemples de signes employés par le compositeur pour indiquer le type de gestes que le chef d’orchestre doit accomplir dans le champ des Kinects. Les flèches indiquent le sens des mouvements à effectuer. Les points signifient qu’il faut rester immobile dans une zone du champ de captation. Le symbole ∞ indique que les gestes sont ad libitum.

Ces signes n’ont qu’un caractère indicatif, le chef devant surtout se laisser guider par son oreille. La durée d’action dans les champs de captation est généralement indiquée par des traits horizontaux ou des flèches lorsque les plages temporelles s’allongent [Figure 10a]. Nordin recourt parfois à des valeurs rythmiques solfégiques pour préciser des gestes ponctuels [Figure 10b].

Figure 10. Sculpting the Air, m.101-105 et m.163-166 [© Part. Peters, 2015]. a) Le chef opère avec sa main gauche des cercles dans le sens antihoraire. b) Le chef réalise avec ses deux mains des gestes linéaires sur chaque temps.

Partie électronique

La partie électronique contient aussi bien des éléments pré-enregistrés que des effets en temps réel que le chef contrôle gestuellement en entrant dans le champ de captation des deux Kinects.

Éléments pré-enregistrés

Comme cela a déjà été évoqué, lorsqu’elles servent de pendules, les clochettes déclenchent périodiquement des sons puisés de manière aléatoire dans un réservoir d’échantillons sonores que le compositeur à conçus en ajoutant de la saturation sur les résonances d’un piano préparé lors de la composition d’une pièce antérieure, Aftermath (2010). Ce type d’actions n’est pas sans difficulté car le chef doit parfois battre la mesure tout en activant ou stoppant le mouvement pendulaire des clochettes. Par ailleurs, si le mouvement est trop étendu, les clochettes sortent du champ de captation en bout de course et rentrent à nouveau dedans à la phase retour, ce qui déclenche deux échantillons au lieu d’un seul.

Média 6. Marc Desmons répétant seul un passage où il doit à la fois diriger les musiciens tout actionnant et en arrêtant avec précision le mouvement pendulaire des clochettes qui déclenchent les échantillons sonores (Ircam, régie de l’espace de projection, 2 mars 2015) [© Arch. Ircam – Bacot-Féron].

De courtes séquences entièrement fixées ont aussi été travaillées en studio et servent d’intermèdes entre certaines sections de l’œuvre. Elles se composent généralement de plusieurs fichiers sons qui se fondent les uns dans les autres, et dont les déclenchements sont assurés depuis la régie. Un long intermède électroacoustique sépare les deux parties principales de l’œuvre. Sa présence impose une césure nette entre les deux parties contrastées, en même temps qu’elle permet au chef d'avoir le temps de repositionner dans la pénombre les clochettes de l’arbre de droite qui, dans la seconde partie, se situe face à lui pour former avec l’arbre de gauche un rideau de clochettes.

Traitements en temps réel

Les traitements en temps réel peuvent être regroupés en deux catégories : les trois effets qui portent directement sur la matière instrumentale produite par les musiciens de l’ensemble (mise en boucle, délai et gel), et le jeu avec des instruments virtuels dans l’application Gestrument. Dans tous les cas, les pixels actionnés par les gestes du chef sont convertis en données MIDI par GestrumentKinectConverter pour contrôler les traitements.

Mise en boucle

L’effet de boucle (“loop”) est activé lorsque la main pénètre dans la zone de captation des caméras Kinect : cela a pour effet de déclencher l’enregistrement de ce que jouent les musiciens en direct. Lorsque le chef retire sa main du champ de captation, l’enregistrement est stoppé et le fragment qui a été enregistré est alors diffusé en boucle sans interruption à travers le réseau de haut-parleurs, et cela jusqu’à ce que l’enregistrement d’une nouvelle boucle soit lancé [Média 7].

Média 7. Marc Desmons répétant avec un effectif réduit de musiciens un passage dans lequel il déclenche l’effet de mise en boucle (Ircam – Studio 5, 23 février 2015) [© Arch. Ircam – Bacot-Féron].

Le fragment musical mis en boucle est altéré par les mouvements de la main dans la zone de captation. En effet, selon la position de la main, la balance des instruments (leur volume relatif) est modifiée au moment même de l’enregistrement. Le point central correspond à un équilibre parfait entre tous les instruments – qui peuvent par ailleurs ne pas tous jouer avec la même dynamique – et les zones périphériques correspondent à un instrument spécifique. Selon le geste opéré, les instruments sont donc tour à tour plus ou moins valorisés. Pour le dire différemment, la zone de captation correspond à une cartographie instrumentale qui, lorsqu’elle est parcourue par la main du chef, met en avant tel ou tel instrument en abaissant le volume des autres signaux enregistrés. Cette variation de volume lors de l’enregistrement est bien sûr conservée dans la boucle.

Délai

Le deuxième effet consiste à appliquer un délai (“delay”) sur ce que jouent les instrumentistes. Son fonctionnement est similaire à l’effet de boucle : l’entrée dans la zone de captation active l’enregistrement dans une mémoire tampon et sa sortie l’interrompt, alors que la balance instrumentale est là encore modulée par la trajectoire gestuelle. Cependant, deux choses diffèrent. D’une part, le signal n’est pas répété en boucle jusqu’à une nouvelle intrusion dans le champ de captation, les répétitions s’interrompant d’elles-mêmes au bout d’un certain nombre d’occurrences, défini par le compositeur. D’autre part, chaque instrument a sa propre période de répétition, comprise entre une et huit secondes, ce qui crée un déphasage entre les lignes instrumentales à mesure qu’elles sont répétées par l’effet.

Gel

Le troisième effet consiste à geler (“freeze”) ce que jouent les instrumentistes à un instant donné. C’est en fait un cas particulier de synthèse granulaire : l’effet est produit en enregistrant une très petite portion du signal sonore entrant – de l’ordre de quelques dizaines de millisecondes. Grâce à une enveloppe sur l’amplitude, il est possible de masquer les clics de la micro-boucle de cet échantillon pour donner l’impression que le son a été littéralement figé en ce moment précis. Une fois actif, l’effet ignore tous les autres signaux entrants (sans quoi la perception du gel du son serait peu convaincante), mais le chef peut néanmoins jouer à nouveau sur la balance instrumentale en déplaçant la main dans la zone de captation [Média 8].

Média 8. Marc Desmons répétant avec un effectif réduit de musiciens un passage dans lequel il opère des effets de gel de la matière instrumentale (Ircam – Studio 5, 23 février 2015) [© Arch. Ircam – Bacot-Féron].

Instruments virtuels

Les données MIDI résultant des gestes du chef dans les zones de captation sont ici transmises à la Workstation UVI qui appelle les instruments virtuels de la banque de sons “Ircam Solo Instruments”. Le jeu avec des instruments virtuels est une transposition littérale du principe de l’application Gestrument, à ceci près que les gestes du chef se déploient dans un espace tridimensionnel alors que l’application offre originellement une surface de jeu bidimensionnelle [Média 9]. Le nombre de pixels activés, relatif à la profondeur du geste dans l’espace de captation, permet de moduler ici le paramètre “pulse density” de Gestrument : plus le nombre de pixels actifs est élevé, plus le nombre de notes jouées sera important, et plus il est bas, plus le nombre de notes jouées sera faible. Comme dans la configuration classique de Gestrument, les gestes au bas de la zone de captation génèrent des sons graves, et en haut, des sons aigus. De la même manière, lorsque les mains du chef se resserrent – et vont vers les musiciens –, il produit des durées courtes et lorsqu’elles s’écartent – et vont vers le public –, il génère des durées longues. Le réservoir de notes est quant à lui basé sur une gamme microtonale folklorique créée avec ScaleGen. Les instruments virtuels sont ainsi actifs sur toute la zone de captation mais sont distribués dans l’espace de diffusion pour simuler les positions des instruments acoustiques sur scène, dans l’idée de créer une sorte de double caché.

Média 9. Marc Desmons répétant seul un passage dans lequel les instruments virtuels contrôlés par Gestrument se superposent à la partie orchestrale, ici jouée en playback. Les écrans d’ordinateur placés devant Jesper Nordin et Manuel Poletti affichent respectivement les zones de captation de la main droite et de la main gauche du chef (Ircam, 12 novembre 2014) [© Arch. Ircam – Bacot-Féron].

Structure de l’œuvre

Sculpting the Air comporte deux parties musicalement très contrastées. Chaque partie se décompose en sous-sections dans lesquelles sont explorées les différents traitements électroniques en temps réel, alors que le chef dirige les musiciens [Figure 11].

Figure 11. Actions gestuelles accomplies par la main gauche (MG) et la main droite (MD) du chef au fil des sections de l’œuvre pour contrôler la partie électronique et/ou activer les clochettes. Il arrive que des effets déclenchés dans une section se poursuivent dans la section suivante comme le déclenchement d’échantillons sonores provoqué par le mouvement (mvt) pendulaire des clochettes.

Première partie

Section I-0 (m.01)

Au tout début de la pièce, le plateau est plongé dans l’obscurité de sorte que le public ne voit que le chef d’orchestre qui actionne silencieusement les clochettes de l’arbre en leur imprimant un mouvement de pendule. Lorsqu’une clochette pénètre dans l’espace de captation, elle déclenche la lecture d’un échantillon sonore tiré de manière aléatoire parmi une vingtaine d’autres, repris de Aftermath (2010) pour quatuor de saxophone et électronique [Média 10]. Le balancement propre à chaque clochette génère tout comme dans Pendulum Music de Steve Reich, des motifs rythmiques complexes et évolutifs, l’amplitude de leur courbe décroissant au fil du temps. En ouvrant ainsi la pièce, le compositeur expose au public le principe de base du dispositif technologique : un espace de captation immatériel et interactif.

Média 10. Sculpting the Air, début de m.01 (Maison de la Musique à Nanterre, 13 juin 2015) [© Arch. TM+, 2015].

Section I-1 (m.02-48)

Alors que des échantillons sonores continuent d’être périodiquement déclenchés en raison du mouvement pendulaire des clochettes toujours en cours, les musiciens de l’ensemble commencent à jouer à un tempo rapide de courtes séquences erratiques qui sont séparées par des moments de silence. Le chef doit battre la mesure tantôt avec la main gauche, tantôt avec la main droite, celle-ci continuant d’actionner ou stopper le mouvement des clochettes alors que la main gauche agit sur la mise en boucle de certains fragments instrumentaux [Média 11]. Cet effet est déclenché à cinq reprises au fil de cette section. Le compositeur recourt à des crochets sur la partition pour indiquer les motifs musicaux mis en boucle. Alors que le dernier motif disparaît progressivement à la fin de cette section, trois fichiers sons de 30 secondes, construits à partir des matériaux enregistrés avec le concours de Florent Jodelet [Figure 2d], forment une trame sonore continue.

Média 11. Sculpting the Air, m.18-25 [© Arch. TM+, 2015].

Section I-2 (m.49-77)

Les motifs erratiques instrumentaux reviennent au début de cette section sans ajout d’effets électroniques. L’effet de boucle est ensuite assuré par les musiciens eux-mêmes qui doivent répéter de courts motifs musicaux dont la superposition produit une texture polyphonique complexe. Lorsque toutes ces boucles instrumentales sont en cours d’exécution, le chef d’orchestre arrête de battre la mesure et se sert alors de ses deux mains pour mettre à nouveau en mouvement les clochettes et déclencher périodiquement les sons de l’introduction [Média 12]. Les musiciens opèrent alors indépendamment les uns des autres un decrescendo de manière à ce que les différents motifs répétés s’estompent progressivement.

Média 12. Sculpting the Air, m.69-77 [© Arch. TM+, 2015].

Section I-3 (m.78-114)

Alors que les clochettes continuent de déclencher les échantillons sonores, l’ensemble construit un canon à quatre voix, chaque voix étant interprétée par une paire d’instruments (m.78 : clarinette 1 + violon 1; m.81 : clarinette 2 + violon 2; m. 83 : alto + clarinette 2; m.84 : clarinette 2 + contrebasse). Pendant ce temps, le chef active les lignes de délai avec sa main gauche (huit fois au total) pour densifier la texture polyphonique [Média 13]. À partir de m.99, Nordin recourt à nouveau à des motifs répétitifs laissant ainsi la possibilité au chef de se concentrer davantage sur le contrôle gestuel des délais.

Média 13. Sculpting the Air, m.78-94 [© Arch. TM+, 2015].

Section I-4 (m.115-126)

Le début de cette section correspond au climax de la pièce. Chaque musicien répète à un tempo rapide (noire = 204) et suivant des intensités extrêmement élevées (fff ou ffff), des motifs comprenant des sons saturés. Le chef ajoute à cela des lignes de délais ayant pour effet de densifier plus encore la texture sonore. À partir de m.119, les musiciens doivent espacer les répétitions pour faire plus de place au silence. Le matériau sonore produit par les musiciens sur scène s’estompe ainsi progressivement laissant plus de place aux échantillons sonores déclenchés par les clochettes. Il ne s’agit alors plus des sons saturés de piano du début mais de sons instrumentaux puisés dans une banque de sons – celle de la bibliothèque de l’orchestre symphonique de Vienne (VSL) lors de la création [Média 14]. Ce glissement progressif se fait collectivement pendant la performance. Le chef choisit un tempo proche de celui imposé par le mouvement pendulaire des clochettes (noire = 116-144). L’ensemble répète alors le même accord plusieurs fois de suite sur chaque premier temps, en jouant de plus en plus fort (de pppp à mp). À m.125, le chef stoppe la battue, signale aux musiciens de ralentir le tempo et de jouer moins fort pour aller vers une dislocation progressive de l’accord jusqu’à sa disparition pour laisser alors place à l’intermède électroacoustique.

Média 14. Sculpting the Air, m.115-122 [© Arch. TM+, 2015].

Seconde partie

Section II-0 (m.127-128)

Cet intermède électroacoustique diffusé dans l’obscurité a été construit à partir des matériaux sonores collectés lors de la session de travail avec Jodelet à l’exception de sons résonants de piano, compressés et distordus entendu lors de l’introduction. Pendant cette transition acousmatique, le chef modifie le positionnement des clochettes de l’arbre de droite afin de former un rideau avec les clochettes de l’arbre de gauche. Pour que les clochettes soient toutes à la même hauteur et se percutent les unes les autres, il doit ajuster précautionneusement la longueur des ficelles. À la fin de l’intermède, il les fait s’entrechoquer plus ou moins délicatement selon les trois indications (NSA, A, VA) utilisées par le compositeur [Média 15].

Média 15. Sculpting the Air, début de m.128 [© Arch. TM+, 2015].

Section II-1 (m.129-157)

La seconde partie de Sculpting the Air est plus douce et mélodique suivant un tempo assez lent (noire = 69) et des dynamiques qui ne dépassent jamais le piano. Deux musiciens (violon 1 et clarinette 1) entament des fragments mélodiques sur l’échelle folklorique microtonale déjà évoquée. Les autres musiciens les rejoignent un à un. Le chef bat la mesure avec la main droite tout en jouant les clochettes avec sa main gauche. Aucun traitement électronique n’intervient dans cette section [Média 16].

Média 16. Sculpting the Air, m.129-143 [© Arch. TM+, 2015].

Section II-2 (mm. 158–211)

Ici, l’activité du chef se complexifie puisqu’il doit continuer à battre la mesure, activer les clochettes mais aussi entrer à nouveau dans le champ de captation des deux Kinects pour jouer avec les instruments virtuels (la banque de sons UVI) via l’application Gestrument. Le réservoir de notes est basé sur la même échelle microtonale ayant guidé l’écriture de la partie instrumentale. Les instruments virtuels sont actifs sur toute la zone de capture de mouvement. Le chef est invité à improviser une “cadence de gestes” (m.171-178 – c’est ainsi qu’elle est appelée lors des répétitions) au dessus d’une pédale de harpe couplée à un trémolo de percussions [Média 17] ce qui permet d’entendre pleinement cet orchestre virtuel sosie de la formation instrumentale sur scène. Gestrument est configuré de manière “classique” : les rythmes deviennent plus rapides lorsque les mains se dirigent vers l’intérieur et plus lents lorsqu’elles se dirigent vers l’extérieur; les hauteurs sont plus aiguës lorsque les mains vont vers le haut et plus graves quand elles vont vers le bas; comme cela a été signalé précédemment, plus le geste est profond, plus le nombre de pixels détectés croît, plus le nombre de notes jouées simultanément est important.

Média 17. Sculpting the Air, m.167-184 [© Arch. TM+, 2015].

Section II-3 (m. 212-265)

Dans cette ultime section au tempo encore plus lent (noire = 58), le matériau instrumental se raréfie et les mesures de silence occupent une place de plus en plus importante. Celles-ci sont partiellement comblées par l’effet de gel que le chef déclenche à douze reprises de manière à figer le plus souvent une hauteur ou un accord spécifique joués par l’ensemble instrumental. Une fois l’effet actif, le chef peut moduler l’équilibre instrumental en déplaçant ses mains dans la zone de captation [Média 18].

Média 18. Sculpting the Air, m.212-224 [© Arch. TM+, 2015].

Conclusion

Sculpting the Air est le fruit d’une étroite collaboration entre le compositeur, le RIM et le chef d’orchestre. C’est pourquoi l’étude en situation s’est imposée pour saisir pleinement les enjeux de cette création musicale avec électronique en temps réel. L’évolution du dispositif technologique – du choix et de la position des capteurs gestuels aux paramètres régis par l’informatique (seuils, filtres, enveloppes, timbres, etc.) – repose sur les phases de test et les nombreux échanges entre Nordin, Poletti et Desmons. Cette approche collaborative du dispositif technologique et des règles conditionnant les interactions électroniques ont largement orienté le processus d’écriture et d’interprétation dans les moments-clés de l’œuvre. Ce projet se plie ainsi à un impératif de médiation constante entre idées compositionnelles, outils technologiques et direction d’orchestre, que la méthode d'analyse adoptée a permis de restituer en détail.

Sculpting the Air est le premier volet d’une trilogie toujours en cours d’écriture et dont le centre de gravité est l’application Gestrument que Nordin a lui-même développée pour ses propres besoins compositionnels. Cet outil, aime-t-il souligner, “minimise et simplifie l’information, tout en permettant de contrôler très finement l’exformation” [Szpirglas, 2020]. Il lui permet donc d’explorer le concept d’exformation, qui se manifeste métaphoriquement dans ce triptyque à travers la médiation électronique : par le traitement du signal en temps réel, un sens additionnel et incarné se superpose à la musique instrumentale à travers un jeu d’échos et de réminiscences. Le deuxième volet de la trilogie Visual Exformation (2016) pour quatuor à cordes, électronique en temps réel et sculpture lumineuse interactive, a été créé au festival Musica de Strasbourg le 4 octobre 2016. Interprétée par le quatuor Diotima, l’œuvre a également été donnée à nouveau avec le concours d’Emmanuel Poletti, mais aussi de Ramy Fischler et Cyril Teste (installation interactive), ainsi que de Thomas Goepfer (réalisation en informatique visuelle).

Le dispositif technologique de Sculpting the Air a aussi été repris dans d’autres œuvres ultérieures du compositeur, comme Emerge (2017) pour clarinette, orchestre et Gestrument, ainsi que Emerging from Currents and Waves (2018) pour clarinette et chef solo, orchestre, électronique et installation visuelle interactive. Sculpting the Air a par ailleurs été interprété une nouvelle fois en 2020 par l’Ensemble intercontemporain, sous la direction de Lin Liao. Le dispositif technologique, par son aspect ludique et relativement accessible, suscite la curiosité des musiciens et amène le compositeur à travailler avec les gestes sans pour autant chercher à “développer de nouveaux langages gestuels” [Szpirglas, 2020]. Sculpting the Air représente à la fois un point d’étape décisif et l’ouverture de nouveaux horizons compositionnels pour Jesper Nordin.

Ressources

Textes

[Bacot et Féron, 2016] – Baptiste Bacot et François-Xavier Féron, “The creative process of Sculpting the Air by Jesper Nordin. Conceiving and performing a concerto for conductor with live electronics”, Contemporary Music Review, vol.35 n°4-5 : “Gesture-Technology Interaction in Contemporary Music”, 2016.

[Nordin, 2015] – Jesper Nordin, “Sculpting the Air – Notice de concert”, Manifeste 2015. (en ligne : https://brahms.ircam.fr/works/work/36339/#program).

[Nørretranders, 1998] – Tor Nørretranders, The User Illusion: Cutting Consciousness Down to Size, traduction anglaise par Jonathan Sydenham, Londres: Penguin Books, 1998.

[Szpirglas, 2020] – Jérémie Szpirglas, “‘Sculpter l’air’. Entretien avec Jesper Nordin, compositeur”, 30 janvier 2020 (en ligne : https://www.ensembleintercontemporain.com/fr/2020/01/sculpter-lair-entretien-avec-jesper-nordin-compositeur/).

[Zattra et Donin, 2016] Laura Zattra et Nicolas Donin, “A questionnaire-based investigation of the skills and roles of Computer Music Designers”, Musicae Scientiae, vol.20 n°3, p.436-456, 2016.

Archives

[Arch. TM+] – Enregistrement vidéo de la création de Sculpting the Air par l’ensemble TM+ sous la direction de Marc Desmons, 13 juin 2015, Maison de la musique de Nanterre.

[Arch. Ircam – Bacot-Féron] – Corpus de données (écrits, audio et vidéo) établi en 2014 et 2015 par les auteurs durant la production de Sculpting the Air. Cette recherche s’inscrit dans le cadre du projet ANR GEMME – Geste musical : modèles et expériences (2012-2016).

[Arch. Ircam – Production] – Jesper Nordin, “Projet Nordin STA TM + présentation”, 2014.

[Arch. Ircam – Ressources]

Jesper Nordin, Sculpting the Air, 13 juin 2015, Maison de la musique de Nanterre

Ensemble TM+ / Marc Desmons (direction), Manuel Poletti (RIM) (en ligne :

https://medias.ircam.fr/xb4904f [concert], https://medias.ircam.fr/xb68755 [générale]).

Jesper Nordin, Sculpting the Air, 7 février 2020, Cité de la musique

Ensemble intercontemporain / Lin Liao (direction), Manuel Poletti (RIM) (en ligne : https://medias.ircam.fr/xe75995 [concert]).

“Sculpting the Air: a conversation with Jesper Nordin and Marc Desmons on building and performing gestural instruments”, journée d’étude Inventing Gestures: New Approaches to Movement, Technology and the Body in Contemporary Composition and Performance, 8 juin 2015, Ircam (en ligne: https://medias.ircam.fr/xe6976a).

Partition

[Part. Peters, 2015] – Jesper Nordin, Sculpting the Air, Henry Litolff’s Verlag C. F. PETERS Leipzig London New York, EP 14106, 2015.

Enregistrements vidéo

[EV Grame, 2011] – “wacom improvising”, vidéo mise en ligne le 20 mai 2011 sur le compte Vimeo du Grame (en ligne : https://vimeo.com/24002171).

[EV Gestrument, 2014] – “GESTRUMENT - The Revolutionary Gesture Instrument for iOS”, vidéo mise en ligne le 24 février 2014 sur le compte Youtube de Gestrument (en ligne : https://youtu.be/J97Ao_3DgQQ).

[EV ScaleGen, 2014] – “ScaleGen”, vidéo mise en ligne le 22 septembre 2014 sur le compte Youtube de Gestrument (en ligne : https://youtu.be/7z3oWqH3EfM).

Remerciements et citation

Nous tenons à remercier très chaleureusement Jesper Nordin, Marc Desmons, Manuel Poletti et Martin Antiphon pour leur disponibilité. Merci aussi aux musiciens de l’ensemble TM+ et à toute l’équipe technique qui a assuré entre autres la captation vidéo de la création.

Pour citer cet article :

Baptiste Bacot et François-Xavier Féron, “Jesper Nordin – Sculpting the Air”, ANALYSES – Œuvres commentées du répertoire de l’Ircam [En ligne], 2021. URL : http://brahms.ircam.fr/analyses/SculptingTheAir/.

Vous constatez une erreur ?

IRCAM

1, place Igor-Stravinsky

75004 Paris

+33 1 44 78 48 43

heures d'ouverture

Du lundi au vendredi de 9h30 à 19h

Fermé le samedi et le dimanche

accès en transports

Hôtel de Ville, Rambuteau, Châtelet, Les Halles

Institut de Recherche et de Coordination Acoustique/Musique

Copyright © 2022 Ircam. All rights reserved.