-

accords-timbres

La musique spectrale travaille sur l'ambiguïté entre harmonie et timbre : en effet, son idée fondatrice est d'analyser des spectres de sons puis de les reconstituer non à l'aide de synthétiseurs (comme pour la synthèse additive) mais d'instruments de l'orchestre qui fusionnent en un son global censé représenter le modèle. Un partiel du spectre devient une note sur la portée. En choisissant un nombre restreint de partiels du spectre, mais particulièrement représentatifs (voir : analyse avec paramètres perceptifs), on peut donc fabriquer des accords qui fusionneront comme des timbres. Les compositeurs jouent ensuite sur ce paramètre de fusion/fission : à l'écoute d'un ensemble d'instruments, lorsqu'on peut discriminer les notes, on est plutôt dans un accord ; alors que lorsqu'on ne perçoit qu'un son fusionné, on est plutôt dans un timbre.

Voir les occurences dans Traiettoria (pour piano et électronique) de Marco Stroppa

Voir les occurences dans Metallics (pour trompette et dispositif électronique) de Yan Maresz

-

axe timbral (classification par)

Dans la musique de Kaija Saariaho entre 1984 et 1995 environ, un système de classification des timbres est utilisé. Les sons sont placés sur un axe timbral allant du son "bruité", comme le bruit blanc, le plus extrême, ou des sons de grosse caisse, des sons écrasés de cordes, au son "clair" ou pur, comme des ondes sinusoïdales, des sons de glockenspiel, des harmoniques de cordes. Il s'agit moins d'une classification objective basée par exemple sur l'harmonicité des sons ou une quelconque description du spectre, qu'une classification métaphorique, chaque son ayant une charge de "luminosité". La musique de la compositrice devient alors un jeu de contrastes sonores.

-

dispositif électroacoustique

-

support fixe

Dès l'avènement des techniques de son enregistrés, des essais ont été réalisés pour créer des œuvres artistiques spécialement liées au support. Aujourd'hui, dans le cadre d'une œuvre électroacoustique, les sons diffusés sur les haut-parleurs peuvent avoir été enregistrés avant le concert, sur un support analogique ou numérique. On parle alors indifféremment de musique sur support fixe, de sons fixés, ou (malgré le support numérique) de musique sur bande.

Dans le cadre d'une musique mixte, mariant instruments acoustiques et sons diffusés sur haut-parleurs, le musicien est forcé de suivre le tempo du son préenregistré, mais également peut s'appuyer pour son interprétation sur la musicalité que le compositeur déploie dans la partie fixe de sa pièce. -

temps réel

Dans le courant de l'histoire de la musique mixte, les pièces mariant instruments acoustiques et sons sur support fixe ont vite montré des limites musicales, notamment en termes d'interaction. La possibilité de traitements numériques du son en direct est née dans les années 1980, et s'est illustrée par des pièces emblématiques de Pierre Boulez (Répons) ou Philippe Manoury (Jupiter). Le son des musiciens est ainsi capté par un microphone, numérisé et envoyé à un ordinateur qui est programmé par le compositeur de manière à construire une partie musicale que l'on appelle "partie électronique". Une partie électronique peut comprendre différents traitements sonores (temporels, timbraux, spectraux...), l'envoi de fichiers son préalablement enregistrés, et enfin la spatialisation de ces éléments dans la salle de concert via les haut-parleurs.

Le rapport du musicien aux sons des haut-parleurs s'inverse : désormais la machine se plie au temps du musicien. Ainsi, pour le musicien, la gestion temporelle redevient libre et une souplesse est réintégrée, qui est celle de l'interprétation. Pour le compositeur, une véritable écriture électronique peut ainsi se mettre en place, plus ou moins voisine d'une écriture orchestrale.Voir les occurences dans Metallics (pour trompette et dispositif électronique) de Yan Maresz

-

support fixe

-

hardware/software

Le "hardware" désigne des composantes matérielles de l'instrumentarium électronique : les machines physiques, comme le synthétiseur Yamaha DX7 ou l'échantillonneur E-Mu Emulator, mais aussi les modules de conversion (interface audionumérique) ou les pédales d'effet. Par opposition, le "software" désigne les éléments logiciels : un patch Max, un effet ou un instrument virtuel, ou un programme d'analyse spectrale par exemple.

-

instrument de musique

-

percussion

Un instrument de percussion est un instrument de musique dont l'émission sonore résulte de la frappe ou du grattage d'une membrane ou d'un matériau résonant. Cette famille d'instrument peut être utilisée dans tous types de musique, de la musique traditionnelle au grand orchestre symphonique de musique classique. Ils constituèrent probablement les premiers instruments de musique et font partie intégrante de la plupart des genres musicaux. On distingue les percussions à peau (ou membranophones) des idiophones. (Wikipédia)

-

piano

Le piano est un instrument de musique polyphonique à clavier de la famille des cordes frappées. Le son du piano est produit par la vibration de ses cordes tendues sur un cadre rigide horizontal (piano à queue) ou vertical (piano droit), placé au-dessus de la table d'harmonie. Elles sont frappées par des marteaux couverts de feutre, actionnés par l'enfoncement des touches du clavier. La vibration des cordes est stoppée par un étouffoir lorsque la touche du clavier est relâchée. Le piano possède le plus souvent un pédalier de deux ou trois pédales, quelques fois quatre sur de récents pianos, permettant d'augmenter son potentiel expressif. (Wikipédia)

-

modes de jeu

BIen que l'instrument soit conçu à l'origine pour être joué à partir du clavier, très vite, les compositeurs ont été tentés de jouer directement sur les cordes, ce qui ouvre un champ de possibilités sonores immense.

Ainsi, avec le piano préparé, popularisé par John Cage, on place différents objets sur et entre les cordes pour créer une sorte de petit orchestre de percussions.

On peut jouer directement sur les cordes, les pédales enfoncées ou pas, avec les doigts, les ongles ou des ustensiles divers.

Il est possible également de jouer des harmoniques sur les cordes en étouffant une corde à un endroit précis puis simultanément en la relâchant et en jouant sur le clavier. - résonance du piano

-

modes de jeu

-

clarinette

La clarinette est un instrument à vent de la famille des bois caractérisée par son anche simple et sa perce quasi cylindrique. Son timbre chaud dans le registre grave, peut s'avérer extrêmement brillant voire perçant dans l'aigu. (Wikipédia)

- Flûte

-

trompette

La trompette est un instrument de musique à vent de la famille des cuivres. La trompette naturelle est fabriquée dans un tuyau de 1m50 de long et constituée par l'embouchure, le tube (ou perce) et le pavillon. La perce est cylindrique, ce qui lui donne un son relativement brillant. (Wikipédia)

-

modes de jeu de la trompette

La trompette peut être jouée avec certains modes de jeux spéciaux, qui sont des stratégies pour aborder le jeu de l'instrument "de côté" : d'une part, ce qui est considéré pour la musique classique comme des imperfections ou des erreurs est ici cultivé, mis en avant, et d'autre part, certaines techniques existantes sont étendues.

Jeu sur l'embouchure- Les souffles, que le musicien utilise pour chauffer l'instrument, sans mettre en vibration ses lèvres, peuvent être travaillés dans leur morphologie musicale,

- les articulations peuvent être également travaillées dans le sens d'une grande virtuosité (doddle, double ou triple coup de langue très usité dans la famille des bois), ou articulations spéciales (pop, slap).

Jeu sur les pistons

- le jeu sur les pistons peut ne pas correspondre à des notes répertoriées : en appuyant à moitié sur les pistons, on trouve des sonorités gauchies, et en les bougeant aléatoirement, on obtient des sortes de trilles assez riches.

Jeu sur la colonne d'air

- comme sur tous les cuivres, le musicien passe d'un mode de résonance du tube à l'autre pour changer de registre. Il est possible de balayer ces registres rapidement : on entend un glissando granuleux, qu'on appelle le rip.

- Le trompettiste peut également jouer dans un mode de résonance inusité qui est le mode fondamental : il joue alors des sons très détimbrés qui sont dans le registre du trombone.

Voir les occurences dans Metallics (pour trompette et dispositif électronique) de Yan Maresz

-

sourdines de trompette

Les sourdines sont des objets qui se fixent sur le pavillon de la trompette pour en modifier la sonorité. Chaque sourdine possède le caractère d'un univers sonore particulier en relation avec un profil de filtrage spectral particulier. La sourdine modifie la sonorité globale de l'instrument en filtrant certaines zones et modifiantl'enveloppe spectrale de l'instrument, mais également modifient parfois la justesse, les transitoires d'attaque et également le rayonnement spatial de l'instrument. Chaque sourdine possède ainsi sa personnalité, sa voix, qui modifie la sonorité riche, le rayonnement directionnel, le caractère puissant et héroïque de l'instrument sans sourdine.

- la sourdine sèche ("straight mute"), la plus communément usitée, notamment en musique classique. Son filtrage favorise les fréquences aigües, d'où une sonorité mordante, percussive et un caractère virtuose et brillant.

- la sourdine "wa-wa" est munie d'un tube coulissant, qui s'utilise enfoncé, tiré, ou enlevé.

- enlevé : on appelle cette sourdine la "harmon", qui possède la sonorité à la fois chaleureuse et distordue popularisée par Miles Davis.

- enfoncé : on passe alors la main devant la sourdine pour obtenir un effet de filtrage qui ressemble à une vocalisation (d'où le nom "wa-wa"), d'un caractère assez ludique.

- à moitié tiré : le son est plus mat que la wa-wa

- la sourdine bol ("cup mute") produit un son velouté, lyrique, introverti, proche d'une clarinette. Son filtrage favorise également les fréquences graves.

- pour obtenir la sourdine "plunger" on peut utiliser une ventouse en caoutchouc. On la déplace devant le pavillon pour obtenir des effets de vocalisation (comme pour la wa-wa).

- la "bucket mute" et la "velvet mute", s'utilisent pour atténuer la brillance de la trompette, en filtrant les composantes hautes du spectre. La bucket est plus efficace, car la velvet ne modifie pas les graves de la trompette.

- Avec la sourdine d'appartement, ou "silent mute" ou encore "whisper mute", faite de matériaux très absorbants, le niveau sonore de la trompette est réduit au maximum. Un filtrage très important est réalisé, l'instrument ne rayonne presque pas, ce qui concourt à déréaliser l'instrument et confère un caractère mystérieux ou de calme, d'intimité.

Voir les occurences dans Metallics (pour trompette et dispositif électronique) de Yan Maresz

-

modes de jeu de la trompette

-

percussion

-

lumière (jeu de)

Au concert, l'éclairage sur scène a pour première fonction de rendre les musiciens visibles, et de pouvoir faire en sorte qu'ils lisent la partition. Généralement, l'éclairage est laissé à la discrétion d'une personne compétente. Parfois les compositeurs eux-mêmes spécifient dans leurs œuvres des effets, comme le passage progressif ou abrupt du noir à la lumière, ou le contraire.

-

méthodes de synthèse (audio)

-

synthèse par fonction d'onde formantique

Une fonction d'onde formantique ou FOF est une onde sinusoïdale à décroissance exponentielle signal élémentaire correspondant à la réponse impulsionnelle d’un filtre du second ordre. Lorsqu’une série de FOFs est déclenchée périodiquement, le résultat produit un son dont la hauteur est l’inverse de cette période, et qui présente un formant centré sur la fréquence interne de chacune des FOFs. La synthèse par FOF a été développée à l’IRCAM pour la synthèse de la voix chantée par ordinateur mise en œuvre à travers le programme CHANT, développé à l'Ircam par l'équipe de Xavier Rodet dans les années 1978-1979.

-

synthèse par modélisation physique

La synthèse par modèle physique est une technique de synthèse sonore fondée sur la description mathématique de la physique de l'instrument. Cette technique a deux raisons d'être. La première est d'ordre artistique. Là où les synthèse par modèle de signaux (additive, soustractive…) ne se contrôlent que par des paramètres descriptifs du son (ce sont donc des données de traitement de signal telles que l'enveloppe du spectre, le taux d'inharmonicité, etc...), les paramètres de contrôle d'une telle synthèse sont des paramètres physiques : géométrie, matériau de l'instrument, type de mouvement des excitateurs, qui sont donc bien plus intuitivement manipulables, lorsqu'il s'agit de faire de la musique. On peut alors imaginer des chimères aux proportions gigantesques (trompette de plusieurs mètres de long, tambour dont la membrane s'épaissit au cours du temps, archet extrêmement rapide avec énormément de pression...).

Le deuxième intérêt est lui d'ordre scientifique : écouter le son produit par la simulation des équations d'un modèle décrivant le fonctionnement est sans doute la manière la plus fiable d'estimer la validité du modèle. - bruit blanc Un bruit blanc est un signal sonore composé de toutes les fréquences (sur la plage 20Hz - 20KHz), chaque fréquence ayant la même énergie. A l'écoute, un tel signal fait penser à un souffle fort. Le bruit blanc est à la base des traitements en synthèse soustractive : comme il comporte toutes les fréquences du spectre audible, il est aisé de lui en enlever telle ou telle partie.

-

interpolation

L'interpolation en mathématiques désigne la définition des points intermédiaires d'une courbe situés entre deux points connus. En musique, il s'agit d'une technique d'écriture voisine du processus : comme lui, elle se définit par le passage progressif d'un état musical à un autre, mais sa particularité est d'être contrôlée informatiquement par un algorithme. On peut par exemple calculer le passage d'un accord à un autre accord. Ainsi, les compositeurs s'aident de programmes d'interpolation pour gérer l'évolution progressives d'harmonies, de rythmes, de timbres, de contours mélodiques…

-

sampler

Un sampler ou échantillonneur est un dispositif matériel ou logiciel qui permet de déclencher la lecture de sons (appelés "échantillons" ou "samples") pré-chargés en mémoire. Ces échantillons peuvent être joués tels quels ou transposés, selon la hauteur de référence demandée par l’utilisateur. En fonction de l'usage qui est fait de l'échantillonneur, les sons produits peuvent évoquer la synthèse sonore ou la musique concrète. La communication avec le sampler se fait le plus souvent sous la forme de messages MIDI de déclenchement, de contrôle et d’interruption, envoyés par le biais d'un clavier maître ou de messages s'il est logiciel.

-

synthèse additive

En physique, la synthèse additive permet d'obtenir une lumière d'une certaine couleur à partir de la combinaison de plusieurs sources colorées. Par analogie, dans le domaine sonore, on peut théoriquement obtenir n'importe quel son en superposant des oscillateurs sinusoïdaux réglés chacun sur un partiel du son à obtenir. La synthèse additive peut être utilisée pour créer des sons ex-nihilo, à partir de règles combinatoires, par exemple. Mais la synthèse additive est l'opération inverse de la transformée de Fourier, qui déduit d'un son une liste de fréquences, d'amplitudes et de phases : on peut resynthétiser des sons par synthèse additive à partir des résultats d'une analyse FFT par exemple.

Voir les occurences dans Traiettoria (pour piano et électronique) de Marco Stroppa

-

synthèse granulaire

La synthèse granulaire construit des sons complexes à partir de courts fragments sonores de quelques milli-secondes joués successivement. Ces fragments sont appelés grains, et sont issus soit de sons enregistrés soit de sons venant d'être joués et placés dans une ligne à retard. Ces grains sont contrôlés par des enveloppes pour éviter des clics dus à des discontinuités de signal. Il est possible de contrôler macroscopiquement ce phénomène au niveau de la densité des grains, de leur hauteur, leur longueur, leur enveloppe, etc.

-

synthèse par modulation de fréquence

La synthèse FM numérique (pour Frequency Modulation, modulation de fréquence) a été mise au point par John Chowning en 1967\. Ce type de synthèse dans son développement le plus simple, met en jeu seulement deux oscillateurs : la fréquence d'un premier oscillateur (signal porteur) est modulée (c'est-à-dire variée régulièrement) par un autre oscillateur (signal modulant). Lorsque la fréquence du signal modulant est en dessous d'environ 30 Hz, on entend une sorte de variation de hauteur, comme un vibrato. Au-delà, c'est un effet timbral qui apparaît. Grâce à la numérisation du signal audio, Chowning a pu contrôler précisément un contenu spectral riche, comprenant de très nombreux partiels, avec un gain de calcul très important par rapport à la synthèse additive.

Voir les occurences dans Traiettoria (pour piano et électronique) de Marco Stroppa

-

synthèse soustractive

A l'opposé de la synthèse additive qui ajoute des sons élémentaires pour former un complexe sonore, la synthèse soustractive part d'un contenu spectral riche pour en enlever certaines parties. Les sons de départ, au spectre riche, sont le plus souvent des bruits blancs, bruits roses, signaux carrés, triangulaires ou en dents de scie. L'opération de filtrage permet d'enlever une ou plusieurs parties du contenu spectral du son d'orgine. Par exemple, le filtrage passe-bas enlève des composantes aigues du son de départ

-

synthèse par fonction d'onde formantique

-

méthodes d’analyse (audio)

L'analyse d'un son permet de le décrire sous forme de nombres, pour pouvoir déterminer précisément la constitution de son spectre pour par exemple le resynthétiser ensuite.

-

Analyse avec paramètres perceptifs

Il a été démontré que certaines analyses sonores ne rendent pas compte de la réalité de la perception. L'algorithme de Terhardt (Terhardt & al 1982) permet de filtrer d'un très grand nombre de valeurs issues d'une analyse spectrale vers des valeurs signifiantes pour la perception. L'algorithme analyse les effets de masquage entre les partiels, introduisant des décalages de hauteur ou la disparition de certains partiels à l'audition. Chaque partiel se voit ainsi attribuer un "poids perceptif". Ainsi, on peut analyser un son extrêmement complexe, et sans parvenir à une image parfaite de ce son, en percevoir l'empreinte harmonique essentielle.

Cet algorithme créé à l'origine par le psychoacousticien Ernst Terhardt et ensuite implémenté à l'Ircam par Andrew Gerzso puis par Gérard Assayag et Dan Timis sous le nom d'Iana.Terhardt, E., Stoll, G., & Seewann, M. «Algorithm for extraction of pitch and pitch salience from complex tonal signals», Journal of the Acoustical Society of America, 1982, 71, 679-688

TODOROFF, DAUBRESSE, FINEBERG : "Iana~ (a real-time environment for analysis and extraction of frequency components of complex orchestral sounds and its application within a musical realization)", ICMC, 1995. -

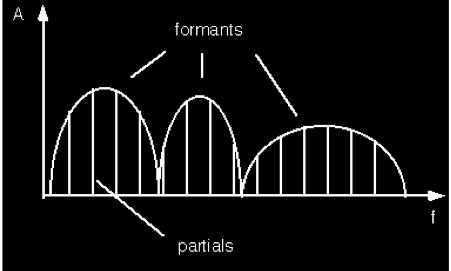

Analyse des formants

Un formant est une zone de fréquences dans le spectre qui contient plus d’énergie que les zones de fréquence voisines. C’est en fait un groupe de partiels qui dépassent dans le spectre.

Un formant est décrit par trois paramètres : - sa fréquence centrale (f), - son amplitude pour la fréquence centrale (a),- sa largeur de bande (bw) (ouverture du formant à un point où l’amplitude est de 3dB inférieure à l’amplitude maximum — la largeur de bande est exprimée en Hz). Un ensemble de formants définit une enveloppe spectrale, c'est-à-dire la répartition de l'énergie des partiels du spectre.

L'analyse des formants d'une voix permet en particulier d'en qualifier les voyelles. Une note chantée sur différentes voyelles garde le même contenu fréquentiel mais la répartition des amplitudes change : les formants bougent.Voir les occurences dans Metallics (pour trompette et dispositif électronique) de Yan Maresz

-

analyse FFT

Basé sur une reformulation optimisée de l'algorithme FFT (pour Fast Fourier Transform, ou transformée de Fourier rapide), l'analyse FFT permet d'extraire à partir d'un son numérisé tous les partiels de ce son. Pour le mathématicien du 18e siècle Fourier, une forme d'onde périodique est décomposable en une superposition de fonctions sinusoïdales. Sur une tranche temporelle donnée, on tente donc de décomposer une forme d'onde complexe en somme de fonctions sinusoïdales, qui possèdent chacune une périodicité (fréquence), une amplitude et une phase.

Ce calcul permet de déduire à partir d'une représentation du son temporelle (une forme d'onde) des données spectrales (une liste de fréquences, amplitudes et phases). Le résultat graphique d'une telle analyse s'appelle un sonagramme.Voir les occurences dans Amers (pour violoncelle et ensemble) de Kaija Saariaho

-

analyse par modèle de résonance

Un modèle de résonance est la modélisation, c'est-à-dire la représentation abstraite, chiffrée, de la résonance d'un son. Ce son n'est donc pas représenté par son contenu spectral seconde après seconde, mais au contraire, par dans sa globalité. Un modèle de résonance se présente sous la forme d'un ensemble de filtres résonants qui correspondent aux formants du son. L'extraction des modèles de résonance d'un son enregistré cherche à déterminer la fixité de certaines zones spectrales, ou fréquences de résonance.

Un modèle de résonance est un modèle vibratoire qui, excité par une courte décharge d'énergie, peut être laissé en résonance, comme un son pincé (pizzicato de contrebasse) ou frappé (cloche). Plus généralement, une source sonore passée dans ces filtres se voit appliquer une sorte de réverbération colorée, à la manière de résonances par sympathie.

-

Analyse avec paramètres perceptifs

-

MIDI

« MIDI » est l’acronyme de Musical Instrument Digital Interface (interface numérique pour instruments de musique), un protocole numérique servant à faire communiquer entre eux en temps réel les instruments électroniques (synthétiseur, sampler, boîte à rythme, ordinateur) qui en sont équipés. Sous l'impulsion de Dave Smith, de Tom Oberheim, ainsi que des représentants des quatre principaux constructeurs japonais d’instruments de musique électronique (Korg, Yamaha, Roland et Kawai), la norme MIDI est officiellement lancée en 1983. Elle repose sur l’adaptation de processus déjà mis en œuvre dans la communication entre terminaux informatiques et permet de synchroniser les machines entre elles par l'envoi de messages, qui spécifient par exemple le début et la fin d'une note, sa hauteur ou sa dynamique. D’abord présent sur les synthétiseurs (le Sequential Circuits Prophet-600 est le premier à en bénéficier), le protocole est progressivement intégré à d’autres machines et devient rapidement le standard de communication entre les instruments électroniques. Le MIDI conduit également au développement d'interfaces gestuelles : les contrôleurs. Comme leur nom l'indique, ils permettent de contrôler d'autres machines (déclencher ou interrompre la lecture d'un échantillon ou d'une séquence, moduler des paramètres) grâce à l'envoi de messages MIDI. Le clavier MIDI est l'un des contrôleurs les plus utilisés.

-

notation spécifique

-

notation de la synchronisation interprète/électronique

Dans une œuvre mixte électronique, les programmes de transformation sont généralement séquentiels : un type d'interaction, de transformation ou de génération sonore réalisé par l'ordinateur sera le même pour un court moment de la partition : généralement quelques notes ou quelques mesures.

Ainsi, il est important que le musicien qui joue la pièce se synchronise avec le déroulement de ces programmes. Dans une situation de temps-réel, par définition, la machine attend le musicien : le plus souvent, on place une pédale au pied du musicien pour qu'il déclenche les différents moments (ou "évenements") prévus du programme, qui sont numérotés sur la partition et le plus souvent entourés d'un cercle.

Lorsque le déroulement de l'œuvre est fixe (le musicien joue au métronome), ces "événements" sont lancés automatiquement. Il existe également des systèmes de "suivi de partition" qui permettent au musicien de jouer sans pédale, et de synchroniser parfaitement et d'une manière "musicale" l'ordinateur au musicien. -

notation de l’électronique

La partie électronique d'œuvres mixtes existe par définition sous forme de programmes informatiques, que le musicien ne peut pas forcément décoder. En effet, la syntaxe de ces programmes peut être différente pour chaque pièce. Il est donc important, pour l'interprète de la partie instrumentale comme pour l'interprète de la partie électronique, que le compositeur schématise ces programmes et les inscrive en regard de la partition musicale.

Le type de notation dépend du style du compositeur et du type d'électronique utilisée. Les œuvres qui utilisent des figures musicales faites de notes seront bien sûr plus faciles à noter, et à lire, que les musiques qui travaillent directement sur des matières de timbre, pour lesquels il n'existe pas de notation standardisée.

Ainsi, la notation de l'électronique peut être de l'ordre de la particelle, c'est-à-dire la notation simplifiée d'une orchestration complexe des éléments musicaux, assortie d'indications verbales ; ou bien tout simplement dessinée sur la partition.Voir les occurences dans Traiettoria (pour piano et électronique) de Marco Stroppa

-

notation de la synchronisation interprète/électronique

- orchestre

-

spatialisation

En musique, l'espace est une notion ambigüe : la spatialisation désigne autant le placement des musiciens sur scène que celui des haut-parleurs dans la salle, ou encore le placement et les mouvements des sons dans des haut-parleurs. Il s'agit pour les compositeurs d'utiliser l'espace comme un élément expressif : l'électronique en temps-réel permet un tel travail.

Voir les occurences dans Dialogue de l'ombre double (version originale pour clarinette et bande) de Pierre Boulez

Voir les occurences dans NoaNoa (pour flûte et électronique) de Kaija Saariaho

- spectralisme

-

traitements

-

delay

Une ligne à retard est un traitement audio qui enregistre un signal et le rejoue après une certaine durée. Le signal retardé peut être rejoué plusieurs fois, ou réenregistré (feedback) pour recréer un écho, par exemple.

Voir les occurences dans NoaNoa (pour flûte et électronique) de Kaija Saariaho

Voir les occurences dans Metallics (pour trompette et dispositif électronique) de Yan Maresz

-

filtres

Module de traitement sonore permettant d'annuler, d'atténuer ou de renforcer certaines zones spectrales d'un son afin de changer sa couleur générale.

Voir les occurences dans NoaNoa (pour flûte et électronique) de Kaija Saariaho

Voir les occurences dans Metallics (pour trompette et dispositif électronique) de Yan Maresz

-

harmoniseur

Module de traitement sonore permettant de changer la hauteur d’un son. Ce module permet au compositeur un travail de type « classique » sur les hauteurs.

Voir les occurences dans NoaNoa (pour flûte et électronique) de Kaija Saariaho

Voir les occurences dans Metallics (pour trompette et dispositif électronique) de Yan Maresz

-

réverbération

La réverbération est un effet sonore visant à reproduire l'ambiance d'un lieu plus ou moins vaste, de la chambre à la cathédrale. La réverbération infinie permet littéralement de faire tenir un son indéfiniment.

Voir les occurences dans NoaNoa (pour flûte et électronique) de Kaija Saariaho

Voir les occurences dans Metallics (pour trompette et dispositif électronique) de Yan Maresz

-

delay